※ 모든 내용을 정리한 것은 아니며, 중요도가 낮거나, 공부하지 않아도 맞출 수 있는 부분은 정리하지 않았습니다.

01 분석 방안 수립 - 중요도 상(★★★)

1. 데이터 분석

- 데이터 분석: 인사이트를 발굴하고 이를 공유하여 의사결정을 지원하는 것을 목표로 데이터를 정의, 수집 변환, 모델링, 시각화하는 과정이다.

- 빅데이터를 활용하기 위한 장애물은 비용보다 데이터 분석을 수행하기 위한 분석적 방법과 성과에 대한 이해의 부족이다.

- 데이터 분석 시 고려사항: 데이터 분석은 규모가 아니라 어떤 시각과 통찰을 얻을 수 있는가의 문제이다.

2. 데이터 분석 기획

- 어떠한 목표를 달성하기 위해 어떠한 데이터를 가지고 어떤 방식으로 수행할 것인가에 대한 일련의 계획을 수립한다.

- 분석기획은 분석 과제 및 프로젝트를 직접 수행하는 것은 아니지만, 성공적인 분석 결과를 도출하기 위한 중요한 사전 작업이다.

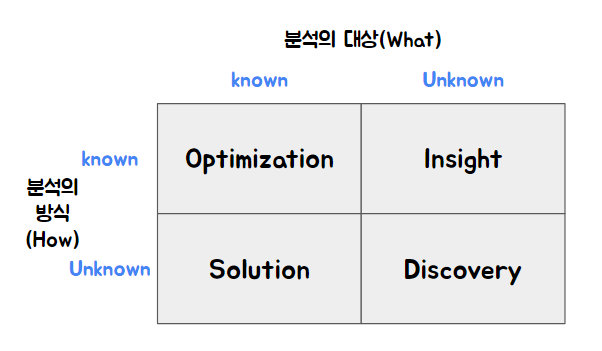

- 분석 기획의 특징: 분석 주제와 방법에 대한 특성상 4가지 유형을 넘나들며 분석을 하고 결과를 도출하는 과정을 반복

(1) Insight: 데이터 분석을 위한 방법은 준비되어 있으나, 무엇을 분석해야 할지 모르는 상황에서 접근하는 영역

- 목표시점에 따른 분류: 단기적, 중장기적, 혼합 방식

- 분석 기획 시 필요역량: 도메인지식, IT지식, 통계적 지식이라는 3가지 역량에 대한 균형 잡힌 시각을 갖고서 분석의 방향성과 계획을 수립

3. 분석 마스터플랜과 로드맵 설정

- 분석 마스터플랜: 분석과제의 목적이나 목표에 따라 전체적인 방향성을 제시하는 기본계획이다.

- 분석 마스터 플랜 수립 절차: 일반적인 정보전략계획(ISP) 방법론 활용, 데이터 분석 기획의 특성을 고려

- IT프로젝트의 우선순위 결정 시에는 전략적 필요성, 시급성, 투자용이성, 기술용이성등 다양한 기준을 정의하여 평가한다.(업무 내재화 수준 X)

- 데이터 분석 프로젝트의 우선순위 결정 시에는 기존 IT프로젝트와 달리, 전략적 중요도, 비즈니스 성과, ROI, 실행 용이성을 고려한다.

- 분석 ROI 요소 4V (Value는 투자비용요소가 아니라 비즈니스 효과 요소임)

| ROI요소 | 특징 |

| 투자비용 요소(Investment) | 크기(Volume) |

| 형태(Variety) | |

| 속도(Velocity) | |

| 비즈니스 효과(Return) | 가치(Value) |

- 분석ROI 요소를 고려한 과제 우선순위 평가기준

| 평가관점 | 평가요소 | ROI요소 |

| 시급성(중요) | - 전략적 중요도 - 목표가치(KPI) | 비즈니스 효과 |

| 난이도 | - 데이터 획득 비용 - 데이터 가공 비용 - 데이터 저장 비용 - 분석 적용 비용 - 분석 수준 | 투자비용 요소 |

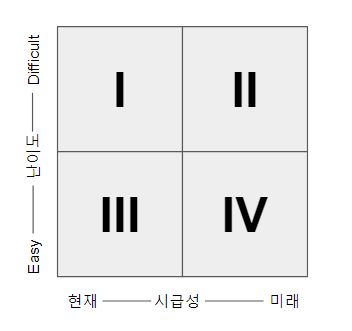

- 분석과제 우선순위 선정 및 조정

(1) 포트폴리오 사분면 분석 기법 활용: 난이도와 시급성을 기준으로 사분면에 배치

. 시급성에 우선순위를 둘 경우: III > I > IV > II

. 난이도에 우선순위를 둘 경우: III > IV > I > II

4. 분석 문제 정의

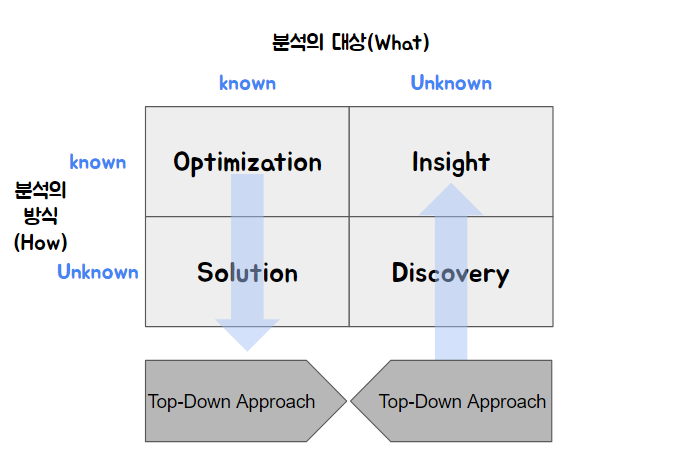

- 분석 과제 도출 방법: 문제가 먼저 주어지고 이에 대한 해법을 찾아가는 하향식 접근 방식과 데이터를 기반으로 문제의 재정의 및 해결방안을 탐색하는 상향식 접근 방식이 있다.

- 하향식(Top-Down Approach) : Optimization > Solution / 전통적 분석 과제 발굴 방식, 근래의 문제들은 변화가 심하여 문제를 사전에 정확하게 정의하기 어렵다. /문제탐색 >문제정의> 해결방안 탐색> 타당성 평가 /비즈니스 모델 캔버스 활용

- 상향식(Bottom-Up Approach) : Discovery > Insight/ 다양의 데이터분석을 통해 왜 그런 일이 발생하는지 역으로 추적하면서 문제를 도출/ 디자인 사고 접근법(사물을 그대로 인식하는 What관점으로 접근), 비지도학습, 빅데이터 환경에서 분석

- 프로토타이핑 : 일단 먼저 분석을 시도해 보고 그 결과를 확인하면서 반복적 개선

- 혼합방식: 상향식 발산(Diverge)-가능한 옵션 도출 > 하향식 수렴(Converge)-분석하고 검증을 반복함.

5. 데이터 분석 방안(중요)

- 분석 방법론: 데이터 분석을 효과적으로 수행하기 위하여 분석 절차를 체계적으로 정리한 방법이다.

- 분석 방법론의 구성요건: 상세한 절차, 방법, 도구와 기법, 템플릿과 산출물, 적당한 난이도(전문적X)

- 계층적 프로세스 모델 구성: 단계, 태스크, 스텝 3단계 구성

- 소프트웨어 개발 생명주기 활용: 계획 > 요구분석 > 설계 > 구현 > 시험 > 유지보수

- 폭포수 모형: 고전적 모형으로 각 단계를 순차적으로 접근하는 방법, 이해가 쉽고 관리가 용이

- 프로토타입모형(원형모형): 사용자의 요구사항을 충분히 분석할 목적으로 시스템의 일부분을 일시적으로 간략히 구현한 다음 다시 요구사항을 반영하는 과정을 반복하는 개발 모형이다. (실험적, 진화적 ) 의사소통을 향상시킨다

- 나선형 모델: 시스템을 개발하면서 생기는 위험을 최소화하기 위해 나선을 돌면서 점진적으로 완벽한 시스템으로 개발하는 모형(대규모 시스템 및 위험 부담이 큰 시스템 개발에 적합, 폭포수와 프로토타입 모형의 단점 보완) 계획수립 > 위험분석 > 개발 > 고객평가 단계로 구성된다.

- 반복적 모형: 사용자의 요구사항이나 제품의 일부분을 반복적으로 개발하여 최종 시스템으로 완성하는 모형 (아래 두 가지 중 어느 것이 더 나은 것은 아니다)

(1) 증분형: 개발 대상 범위를 확대해 최종 제품을 완성(조각 케이크)

(2) 진화형: 핵심 부분을 개발한 후 각 구성요소를 지속적으로 발전(롤케이크)

- KDD 분석 방법론: 통계적인 패턴이나 지식을 탐색하는데 활용할 수 있도록 체계적으로 정리한 프로파일링 기술기반의 데이터 마이닝 프로세스/데이터 마이닝, 기계학습, 인공지능, 패턴인식, 시각화에 응용가능

- KDD 분석 절차: 데이터셋 선택 > 데이터 전처리 > 데이터 변환 > 데이터 마이닝 > 데이터 마이닝 결과 평가 5단계

- KDD 분석 방법론 9가지 프로세스: (1) 도메인의 이해, (2) 분석 대상 데이터셋 선택 및 생성, (3) 데이터 전처리, (4) 데이터 변경, (5) 데이터 마이닝 기법 선택, (6) 데이터 마이닝 알고리즘 선택, (7) 데이터 마이닝 시행, (8) 결과 해석, (9) 지식 활용

절차와 방법론의 단계가 다르다.

- CRISP-DM 4 계층 : 최상위레벨 > 일반화 태스크 > 세분화 태스크 > 프로세스 실행

- CRISP-DM 분석 방법론: 업무이해 > 데이터 이해> 데이터 준비 > 모델링 > 평가 > 전개(업무이해와 전개는 KDD에는 없음)

- SEMMA 분석 방법론(Sample(추출), Explore(탐색), Modify(수정), Model(모델링) and Assess(평가))는 SAS 주도로 만들어진 기술과 통계 중심 데이터 마이닝 프로세스이다. (5단계)

6. 빅데이터 분석 방법론

- 빅데이터 분석 방법론 개요: 응용 서비스 개발을 위한 3 계층 단계 > 태스크 > 스텝

- 빅데이터 분석을 위한 단계: 분석 기획 > 데이터 준비 > 데이터 분석 > 시스템 구현 > 평가 및 전개

- 데이터분석 단계에서 텍스트 분석을 위해 용어사전이 필요하다.

- 빅데이터 분석 방법론에서는 데이터 분석에 분석용 데이터 준비, 텍스트 분석, 탐색적 분석, 모델링, 모델 평가 및 검증 단계가 모두 들어간다.

7. 데이터 분석 거버넌스

- 데이터 분석 업무를 하나의 기업 문화로 정착하고 이를 지속적으로 고도화해 나가기 위해 필요하다.

- 데이터 분석 거버넌스의 구성요소: 조직, 프로세스, 인프라, 데이터, 교육 체계

- 데이터 분석 지원 인프라: 데이터 분석 플랫폼 구축

- 데이터 분석 플랫폼의 구성요소

(1) 협의: 데이터 처리 프레임 워크, 분석 엔진, 분석 라이브러리

(2) 광의: 협의 + 분석 서비스 제공 엔진, 분석 애플리케이션, 분석 서비스 제공 API, 운영체제

- 데이터 거버넌스: 전사 차원의 모든 데이터에 대하여 정책, 지침, 표준화, 운영조직과 책임등의 표준화된 관리 체계를 수립하고 운영하기 위한 프레임워크와 저장소를 구축하는 것이다.

- 데이터 거버넌스의 필요성: 개별 시스템 단위로 데이터를 관리할 경우, 데이터 중복, 비표준화에 따른 정합성 오류 등으로 데이터 활용도가 저하될 수 있다. 빅데이터 프로젝트의 효과적 추진 및 효과의 지속성을 얻기 위해서는 데이터 거버넌스 체계 수립이 필요하다.

- 데이터 거버넌스 주요 관리 대상:마스터 데이터(키값 등), 메타 데이터(데이터 설명), 데이터 사전(자료의 이름, 표현 방식 등)

- 데이터 거버넌스의 특징: 데이터의 가용성, 유용성, 통합성, 보안성, 안정성

- 데이터 거버넌스의 구성요소: 원칙(데이터 유지/관리를 위한 지침, 보안, 품질기준, 변경관리 등), 조직, 프로세스,

- 데이터 거버넌스 체계: 데이터 표준화, 데이터 저장소 관리, 표준화 활동(표준 준수 여부를 주기적 점검)

- 데이터 분석 교육 및 마인드 육성 체계

(1) 필요성: 데이터 분석의 가치를 극대화하고 내재화하여 안정적인 추진기로 접어들기 위해 필요

. 새로운 체계를 도입하고자 할 경우 저항이나 기존 형태로 돌아가고자 하는 관성이 발생한다.(사티어 변화모델과 비슷하게 생각하면 됨)

(2) 데이터 분석 문화 도입방안

. 데이터 분석 고입에 대한 문화적 대응: 준비기 > 도입기 > 안정 추진기 (대부분 도입기에서 되돌아가고자 하는 관성 때문에 포기)

. 적극적 도입방안: 적합한 데이터 분석 과제 도출, 데이터 분석 조직 마련, 데이터 분석 마인드 형성을 위해 지속적 교육과 훈련, 데이터 기반 의사결정을 할 수 있는 기업문화 정착 활동

. 데이터 분석 교육 방향: 도구 사용법이 아닌 데이터 분석 역량 확보/강화, 데이터 분석 큐레이션 교육, 분석 기법 및 도구 사용 교육, 데이터 분석 기회발굴과 시나리오 작성법 교육, 분석적 사고 향상 교육, 데이터분석과 활용이 문화로 받아들여지도록 유도

8. 데이터 분석 수준진단

- 데이터 분석 수준진단 필요성과 목표: 데이터 분석 도입 여부와 활용을 위한 현 상태에 대한 명확한 점검 필요. 데이터 분석 수준을 명확히 이해하고 진단 결과를 바탕으로 미래 목표 수준 정의

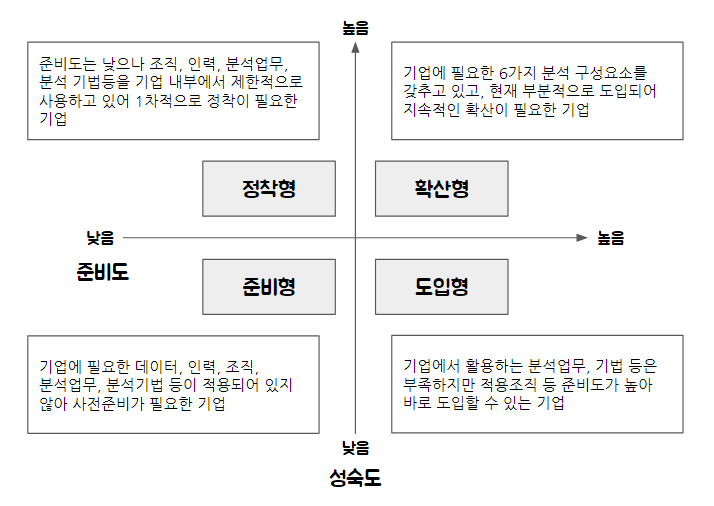

- 분석 준비도: 조직 내 데이터 분석 업무 도입을 위한 현재 수준 판단 (6개 영역: 분석업무, 분석인력 및 조직, 분석 기법, 분석 데이터, 분석 문화, 분석 인프라)

- 분석 성숙도: 데이터 분석 능력 및 데이터 분석 결과 활용에 대한 조직의 성숙도 수준 평가

(1) 3개 영역: 비즈니스, 조직 및 역량, IT

(2) 각 영역별 성숙도 수준에 따라 도입, 활용, 확산, 최적화 단계로 구분

- 분석 수준진단 결과: 현재 수준 파악

- 사분면 분석

01 분석 작업 계획 - 중요도 하(★)

1. 분석 작업 개요

- 데이터 처리 프로세스는 데이터 처리 영역과 데이터 분석 영역으로 나누어진다.

- 데이터 처리 영역: 데이터 소스 > 데이터 수집 > 데이터 저장 > 데이터 처리

- 데이터 분석 영역

(1) 데이터 분석: 도메인이슈도출 > 분석목표 수립> 프로젝트 계획 수립 > 보유 데이터 자산 확인

(2) 데이터 표현: 시각화

2. 데이터 확보 계획

- 데이터 확보를 위한 사전 검토 사항: 필요 데이터 정의, 보유 데이터 현황파악, 분석 데이터 유형, 데이터 규모, 내부 데이터 목록, 외부 데이터 수집

- 분석에 필요한 변수 정의: 데이터 분석 요건에 따라 도출된 활용 시나리오에 적합한 데이터의 유형 및 분석 변수를 정의한다.

- 분석 변수 생성 프로세스 정의: 분석 대상에 대해 객관적으로 인식하고 인과 및 상관관계 분석을 위한 분석 변수 생성 프로세스 정의

- 생성된 분석 변수의 정제를 위한 점검항목 정의 : 도출된 데이터에 대해 가용성을 평가하고 점검항목을 정의한다.

(1) 분석 변수 점검항목: 데이터 수집, 데이터 적합성, 특징 변수, 타당성, 다양성(X)

- 생성된 분석 변수의 전처리 방법 수립: 데이터 정제를 위한 점검항목 정의 후 논리적 모형 설계를 위한 데이터 전처리 방법을 수립한다.(정제, 통합, 축소, 변환)/ 정제와 통합을 통해 60~80% 전처리 된다.

- 생성 변수의 검증 방안 수립

(1) 분석 변수의 데이터 검증 방안 수립: 모든 개별 데이터에 대한 타당성 보장 보다 빅데이터 개념 및 특성 측면에서 정의, 빅데이터 품질관리 및 검증은 정확성보다는 데이터의 양이 충분한지에 대한 충분성 개념하에 검증(정확성, 완전성, 적기성, 일관성)(편의성X)

(2) 데이터 검증 체계 수립: 데이터 출처, 중복 데이터, 컴플라이언스 이슈, 다양성, 데이터양, 품질 지표 조건 만족여부, 분석 검증 테스트 분리여부 등 (타당성 X)

3. 분석 절차와 작업 계획

- 분석 절차의 특징: 데이터 분석의 기본적 과정, 분석 방법론을 구성하는 최소 요건, 상황에 따라 단계를 추가할 수도 있으며 생각 가능

- 일반적인 분석 절차: 문제 인식, 연구조사, 모형화, 데이터 수집, 데이터 분석, 분석 결과 제시

- 분석 절차 적용 시 고려사항: 문제에 대한 구체적 정의가 없다면 데이터 마이닝 기반으로 데이터를 분석하여 인사이트를 발굴하거나 일단 데이터 분석을 시도한 후 결과를 확인해 가면서 반복적으로 개선 결과를 도출해 볼 수 있다.

- 분석 작업 계획: 프로젝트 소요비용 배분, 프로젝트 작업 분할 구조 수립, 프로젝트 업무 분장 계획 및 배분

- 작업분할구조(WBS: Work Breakdown Structure): 프로젝트의 범위와 최종 산출물을 세부요소로 분할한 계층적 구조도

- 검정(테스트): 가설을 세우고 가설이 맞는지 틀리는 지를 판단.

- 검증(증명): 틀릴 가능성이 없음을 경험적 검사 또는 실험으로 밝히는 것

- 분석 목표 정의서: 문제 개선 방향에 맞는 현실적인 분석 목표를 수립하여 필요한 데이터에 대한 정보나 분석 타당성 검토 및 성과측정 방법 등을 정리한 정의서이다. 필요한 데이터를 정의하고, 분석 방법과 데이터 수집 및 분석 난이도, 수행 주기, 분석 결과에 대한 검증 기준을 설계

4. 분석 프로젝트 관리

- 분석 프로젝트: 도출된 결과의 재해석을 통한 지속적인 반복과 정교화가 수행되는 경우가 대부분이다.

- 지속적인 반복을 고려하여 프로젝트 관리방안 수립

- 분석프로젝트의 추가적 속성: 데이터 크기, 데이터 복잡도, 속도, 분석 모형의 복잡도, 정확도와 정밀도

- 분석 프로젝트는 데이터 분석이 갖는 기본 특성(5V)을 살려 프로젝트 관리 지침을 만들어 기본 가이드로 활용해야 한다.

- 분석 프로젝트의 영역별 주요 관리 항목: 범위, 일정, 원가, 품질, 통합, 조달(상황에 따라 분석 프로젝트의 목적에 적합한 범위 내에서 외부에 아웃소싱을 수행할 수 있다.), 인적자원, 위험, 의사소통, 이해관계자 관리 등

※ 참고서적

| 서명 | 이기적 빅데이터분석기사 필기2022 |

| 저자 | 나홍석, 배원성, 이건길, 이혜영 공저, 고려사이버대학교AI, 빅데이터 연구소 |

| 출판사 | 영진닷컴 |

'데이터분석과 AI > 빅데이터 분석기사' 카테고리의 다른 글

| [빅데이터분석기사 필기] Part02. 빅데이터 탐색-Ch03. 통계기법의 이해 (0) | 2023.04.05 |

|---|---|

| [빅데이터분석기사 필기] Part02. 빅데이터 탐색-Ch02. 데이터 탐색 (0) | 2023.04.02 |

| [빅데이터분석기사 필기] Part02. 빅데이터 탐색-Ch01. 데이터 전처리 (0) | 2023.04.01 |

| [빅데이터분석기사 필기] Part01. 빅데이터 분석 기획-Ch03. 데이터 수집 및 저장 계획 (0) | 2023.03.30 |

| [빅데이터분석기사 필기] Part01. 빅데이터 분석 기획-Ch01. 빅데이터의 이해 (4) | 2023.03.26 |

댓글